LLMs en Local (II): Ollama

- 17 ago 2025

- 4 Min. de lectura

Actualizado: 19 ago 2025

1. Introducción: ¿Por qué Ollama?

Tras explorar en el primer capítulo cómo usar LM Studio para ejecutar modelos de lenguaje de forma local con una interfaz gráfica intuitiva, llega el momento de conocer una alternativa pensada para quienes prefieren rapidez, ligereza y control desde la línea de comandos: Ollama.

Ollama permite descargar y ejecutar modelos de lenguaje en tu ordenador con un par de comandos. No requiere configuraciones complicadas, se instala rápido y está pensado para ofrecer una experiencia fluida sin depender de la nube.

2. ¿Qué es Ollama y cómo funciona?

Ollama es una herramienta de código abierto diseñada para ejecutar LLMs en local de forma sencilla. Se controla íntegramente desde la terminal, lo que la convierte en una opción ideal para usuarios que se sientan cómodos trabajando con comandos o que quieran integrar modelos en scripts y aplicaciones.

Características clave:

Descarga automática de modelos en formato optimizado.

Ejecución inmediata sin instalaciones adicionales de dependencias complejas.

API local integrada para conectar con otras aplicaciones.

3. Ventajas y desventajas de Ollama

Aspecto | Ollama | LM Studio |

Interfaz | Terminal (CLI) | Gráfica (GUI) |

Instalación | Muy rápida | Sencilla pero más pesada |

Modelos soportados | Amplia lista preconfigurada | Modelos en GGUF |

API local | ✅ Incluida | ❌ No nativa (requiere herramientas extra) |

Curva de aprendizaje | Media (requiere aprender comandos) | Baja |

Ventajas de Ollama:

Instalación mínima y rápida.

API lista para usar.

Fácil de automatizar e integrar.

Desventajas:

Sin interfaz gráfica.

Menos opciones visuales para gestionar modelos.

4. Instalación de Ollama

Descarga el archivo de instalación de la web de Ollama

A modo de ejemplo haremos la instalación en Windows

Se descarga un archivo OllamaSetup.exe

Download Ollama

Ejecutar el instalador:

Ejecutamos archivo descargado "OllamaSetup.exe"

Seguir las instrucciones del asistente de instalación hasta completar.

Comprobar que se ejecuta en segundo plano:

Una vez finalizada la instalación, OLLAMA debería iniciarse automáticamente.

Verifica que aparece su icono en la bandeja del sistema (al lado del reloj, donde están los iconos ocultos).

Abrir una ventana de comandos (CMD)

Presiona Win + R, escribe cmd y pulsa Enter.

Escribe "Ollama" en la ventana de comandos y si está instalado te aparecerá algo como lo que se ve en la siguiente imagen

Ollama - Consola

5. Uso básico

El modo básico de funcionamiento es a través de la ventana de comandos. Desde ahí descargaremos los modelos y también interactuaremos con ellos.

5.1. Descargar un modelo

Lo primero que tendremos que hacer es descargar un modelo. Para saber que modelos podemos descargar iremos a la web de Ollama: https://ollama.com/library

En la zona de "Library" aparecen todos los modelos descargables y como se descarga.

A modo de ejemplo vamos a descargar el modelo "llama3.2". Lo seleccionamos y se nos abrirá el siguiente enlace: "https://ollama.com/library/llama3.2"

En esa página podemos ver las distintas versiones a descargar del modelo y especificaciones del mismo.

En nuestro caso vamos a descargar la última versión.

En la parte de arriba nos indica que hay que teclear en la ventana de comandos para poder descargarlo y ejecutarlo. En este caso, vamos sólo a descargarlo y lo usaremos luego así que usaremos "pull" en lugar de "run"

ollama pull llama3.2

5.2. Iniciar un chat

Para iniciar el chat tendremos que ejecutar el comando "run" sobre alguno de los modelos que tengamos descargados.

Para ver la lista de modelos descargados podemos usar el comando "list" de ollama

ollama list

Para iniciar el chat usaremos el comando "run". en nuestro caso:

Ollama run llama3.2

y el modelo quedará a la espera de tus preguntas directamente desde el terminal.

Escribimos tras los simbolos ">>>" lo que queramos preguntar

genérame el texto para un tweet hablando sobre la Catedral de León (España)

Para salir y terminar la conversación, tendremos que usar el comando "/exit"

/exit6. Caso práctico: usando los modelos de lenguaje open-source de OpenAI en Ollama

En agosto de 2025, OpenAI publicó varios modelos de lenguaje open-source bajo licencia libre, permitiendo que cualquier persona los descargue y ejecute en su propio ordenador.

Ollama ya permite la descarga de estos modelos llamados "gpt-oss"

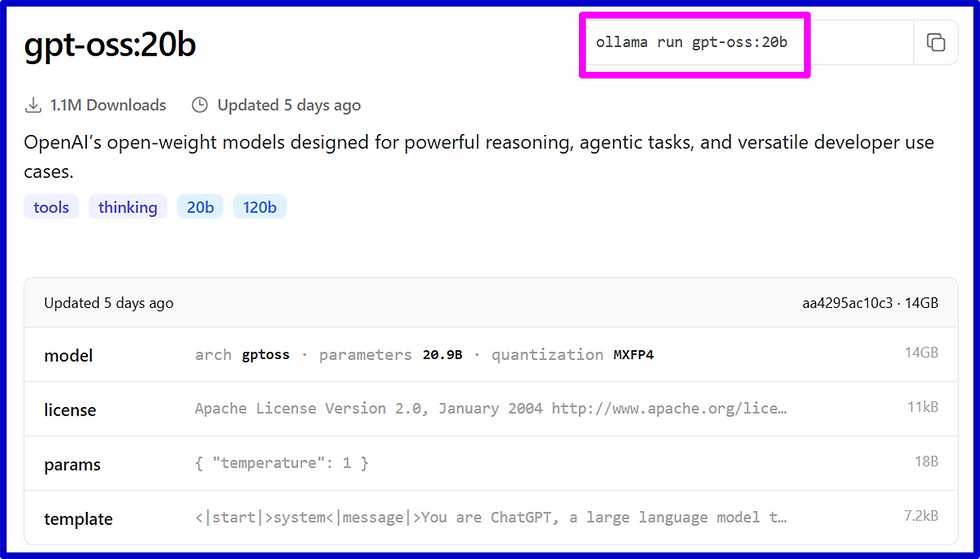

Para descargar el modelo, iremos a la librería de Ollama y seleccionaremos los modelos "gpt-oss" y se nos abrirá la siguiente página: "https://ollama.com/library/gpt-oss"

Vemos que actualmente hay 2 opciones:

gpt-oss:20b de 14Gb

gpt-oss:120b de 65Gb

Vamos a descargar el "gpt-oss:20b": "https://ollama.com/library/gpt-oss:20b"

Vamos a descargar (pull) el modelo. Para ello desde la ventana de comandos (terminal) escribimos:

ollama pull gpt-oss:20b

Ahora ya podemos interactuar con el modelo desde la ventana de comandos (terminal):

Nota: al estar usando un modelo de razonamiento, podemos ver su cadena de pensamiento (thinking) antes de ver la respuesta final.

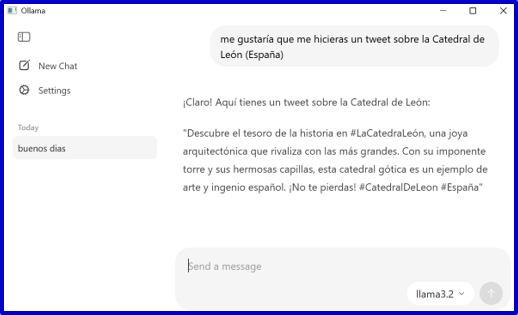

7. Ollama: modo gráfico

En las primeras versiones de Ollama sólo se podía interactuar con los modelos en modo consola. Ahora ya existe una aplicación que nos permite interactuar con los modelos desde una ventana

Para ello, al instalar Ollama se nos habrá instalado una aplicación de nombre "Ollama" a la que podemos acceder desde el menú Inicio de Windows:

Se nos abre una ventana con una interfaz donde podemos seleccionar el modelo e interactuar con el modelo seleccionado.

8. Conclusión

Ollama demuestra que no hace falta una interfaz compleja para aprovechar el poder de los LLMs en local. Su instalación rápida, soporte para múltiples modelos y API integrada lo convierten en una de las opciones más eficientes para quienes buscan simplicidad, velocidad y control total desde la terminal.

Comentarios