LLMs en Local (III): Open WebUI

- 20 ago 2025

- 4 Min. de lectura

1. Introducción: WebUI, el todo en uno para LLMs

Tras explorar LM Studio (la opción más sencilla) y Ollama (la más ligera y minimalista), llega el momento de dar un paso hacia la herramienta más potente y flexible para ejecutar modelos de lenguaje en local: WebUI.

Este proyecto de la comunidad se ha convertido en la referencia para quienes buscan control total: soporte para múltiples modelos, configuraciones avanzadas y un ecosistema de extensiones que permite desde leer documentos hasta crear agentes conversacionales con memoria.

Gracias a Pinokio, su instalación ya no requiere conocimientos de Python ni de entornos virtuales. Ahora se puede tener WebUI funcionando en cuestión de minutos.

2. ¿Qué es WebUI?

WebUI es una plataforma de código abierto que ofrece una interfaz gráfica muy completa para ejecutar LLMs en local.

Sus principales características:

Compatible con múltiples formatos: GGUF, GPTQ, AWQ, FP16, etc.

Se actualiza con frecuencia gracias a una comunidad muy activa.

Pensado para usuarios avanzados que quieran experimentar con todo tipo de modelos y configuraciones.

En resumen: si LM Studio es ideal para empezar, WebUI es perfecto para exprimir al máximo las posibilidades de los LLMs en local.

3. Ventajas de WebUI

Aspecto | LM Studio | Ollama | WebUI |

Interfaz | Gráfica simple | Solo terminal (CLI) | Gráfica avanzada |

Instalación | Muy sencilla | Súper rápida | Compleja (pero fácil con Pinokio) |

Modelos soportados | GGUF | Modelos preconfigurados | GGUF, GPTQ, AWQ, FP16, etc. |

Extensiones | ❌ No | ❌ No | ✅ Sí, gran variedad |

API local | ❌ No nativa | ✅ Sí | ✅ Sí |

Nivel de usuario | Principiante | Intermedio | Avanzado |

Ventajas clave de WebUI:

Flexibilidad total.

Interfaz con muchas opciones.

Plugins que amplían sus capacidades.

Gran comunidad y soporte.

4. Instalación de WebUI desde Pinokio

Normalmente, instalar WebUI manualmente implica clonar repositorios de GitHub, configurar entornos Python y resolver dependencias. Con Pinokio, este proceso se simplifica al máximo

Nota: Si quieres ver como se instala PINOKIO, lee nuestro anterior articulo "Generación de imágenes con IA en Local (II): PINOKIO donde se explicaba en detalle el proceso de instalación y uso de PINOKIO

Instalación de WebUI

1️⃣ Abre PINOKIO en tu ordenador

Asegúrate de que está actualizado a la última versión para evitar errores de compatibilidad

2️⃣ Accede a la sección “Discover” y busca “ComfyUI”.

"Discover" aparece en la parte superior derecha de la ventana principal.

Esta sección permite explorar e instalar nuevas herramientas de IA compatibles con Pinokio

3️⃣ Utiliza el buscador para escribir "WebUI".

Asegúrate de seleccionar la versión oficial del desarrollador y revisa la descripción y requisitos si es necesario.

4️⃣ Haz clic en "One-Click Install with Pinokio".

Acepta los permisos y sigue los pasos guiados.

La instalación de Open WebUI requiere que tengas instalado en tu sistema "Ollama"

La instalación de Ollama la vimos en nuestro artículo anterior:

El sistema descargará automáticamente los archivos necesarios y resolverá las dependencias sin intervención manual.

Este proceso tardará varios minutos y dependerá de la conexión de internet que tengas ya que se descargarán varios gigas de información

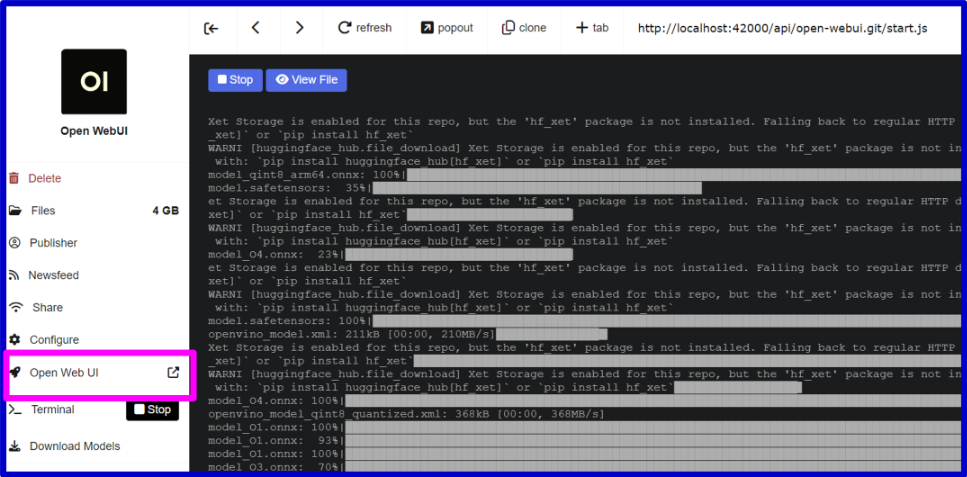

5️⃣ Inicia Open WebUI desde PINOKIO y se abrirá su interfaz local en el navegador.

Una vez completada la instalación, Open WebUI aparecerá en la sección principal de aplicaciones instaladas.

WebUI - Arrancar

Haz clic en "Open WebUI" para ejecutarla.

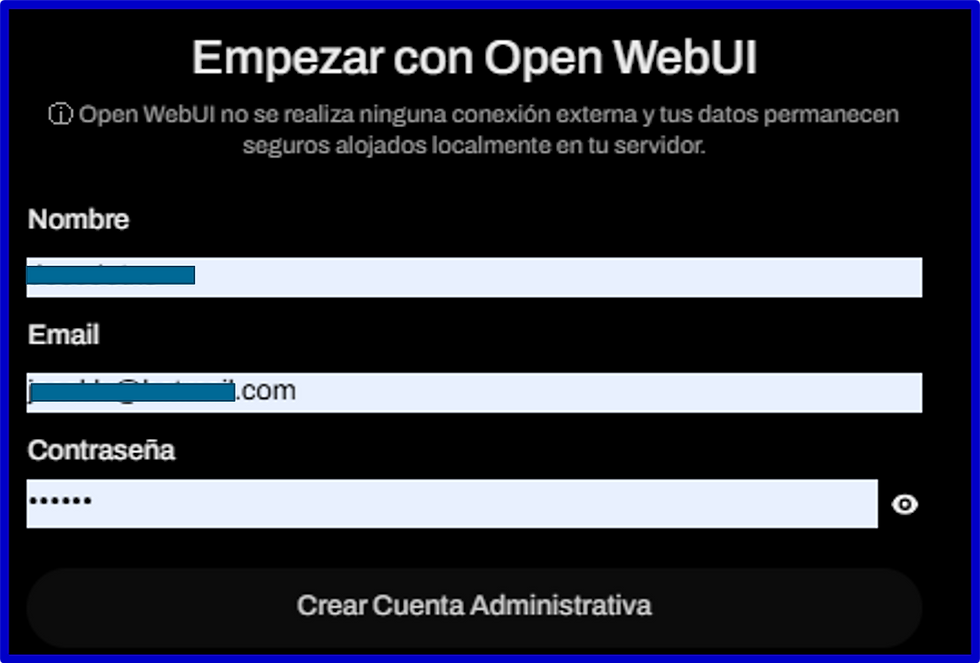

WebUI - Open Web UI Si es la primera vez, te va a pedir un nombre de usuario, e-mail y contraseña.

Se usa para identificarse dentro de tu ordenador. No realiza ninguna conexión externa, todo queda alojado en tu propio equipo.

Empezar con Open WebUI

5. Primeros pasos en WebUI

Al abrir WebUI encontrarás una interfaz tipo Chat de IA:

Model → para seleccionar y cargar modelos.

Vas a poder seleccionar entre otros. los modelos que tienes descargados en Ollama

Parameters → donde ajustar opciones como temperatura, top-k, top-p o tamaño de contexto.

Chat → el entorno para conversar con el modelo.

Settings → configuración general de la aplicación.

6. Caso práctico: probando un modelo en WebUI

Al igual que hicimos en artículos anteriores, vamos a usar los modelos de lenguaje open-source de OpenAI

Desde WebUI, ve a Model y selecciona Load Model.

Una vez cargado, vete a la zona Chat.

Escribe tu primer prompt, por ejemplo:

Genérame el texto para un tweet sobre la Catedral de León (España)El modelo responderá en segundos, y podrás ir ajustando parámetros para modificar su estilo y creatividad.

7. Extensiones y funciones avanzadas

WebUI no es solo un chat. Gracias a su sistema de extensiones, puedes añadir funciones avanzadas como:

Memoria larga: el modelo recuerda conversaciones anteriores.

Lectura de PDFs y TXT: sube documentos y pide resúmenes.

Roleplay: crea personajes virtuales y escenarios interactivos.

Integración con APIs externas: para conectar el modelo con otras herramientas.

Esto convierte a WebUI en una plataforma ideal no solo para experimentar, sino también para proyectos más complejos.

9. Conclusión

Text Generation WebUI es, sin duda, la herramienta más completa para ejecutar LLMs en local. Su enorme flexibilidad, la compatibilidad con múltiples formatos y la posibilidad de ampliarlo mediante extensiones lo convierten en la opción favorita de la comunidad.

Gracias a Pinokio, su instalación es fácil y accesible, permitiendo a cualquier usuario tener un entorno profesional en pocos minutos.

Si buscas potencia, opciones avanzadas y una plataforma que crezca contigo, WebUI es tu mejor aliado en el mundo de los LLMs en local.

🌐 Recursos útiles

Web de Open WebUI: https://docs.openwebui.com/

Web de PINOKIO: https://pinokio.co/

📚 Otros artículos del blog relacionados

Instalación de Pinokio: Generación de imágenes con IA en Local (II): PINOKIO

Instalación de Ollama: LLMs en Local (II): Ollama

Uso de LM Studio: LLMs en Local (I): LM Studio

Comentarios